“ Ele é o meu médico, o meu psicólogo, o meu médico de emergência, ele é tudo para mim.» A declaração de Marta Díaz durante uma transmissão ao vivo no TikTok poderia parecer uma piada, se não fosse pelo facto de milhões de jovens a ouvirem como algo completamente normal. A influenciadora, com quase 12 milhões de seguidores no TikTok, Instagram e YouTube, verbalizou uma mudança profunda: os jovens já não usam a IA apenas para estudar ou trabalhar, mas também para gerir a sua saúde mental.

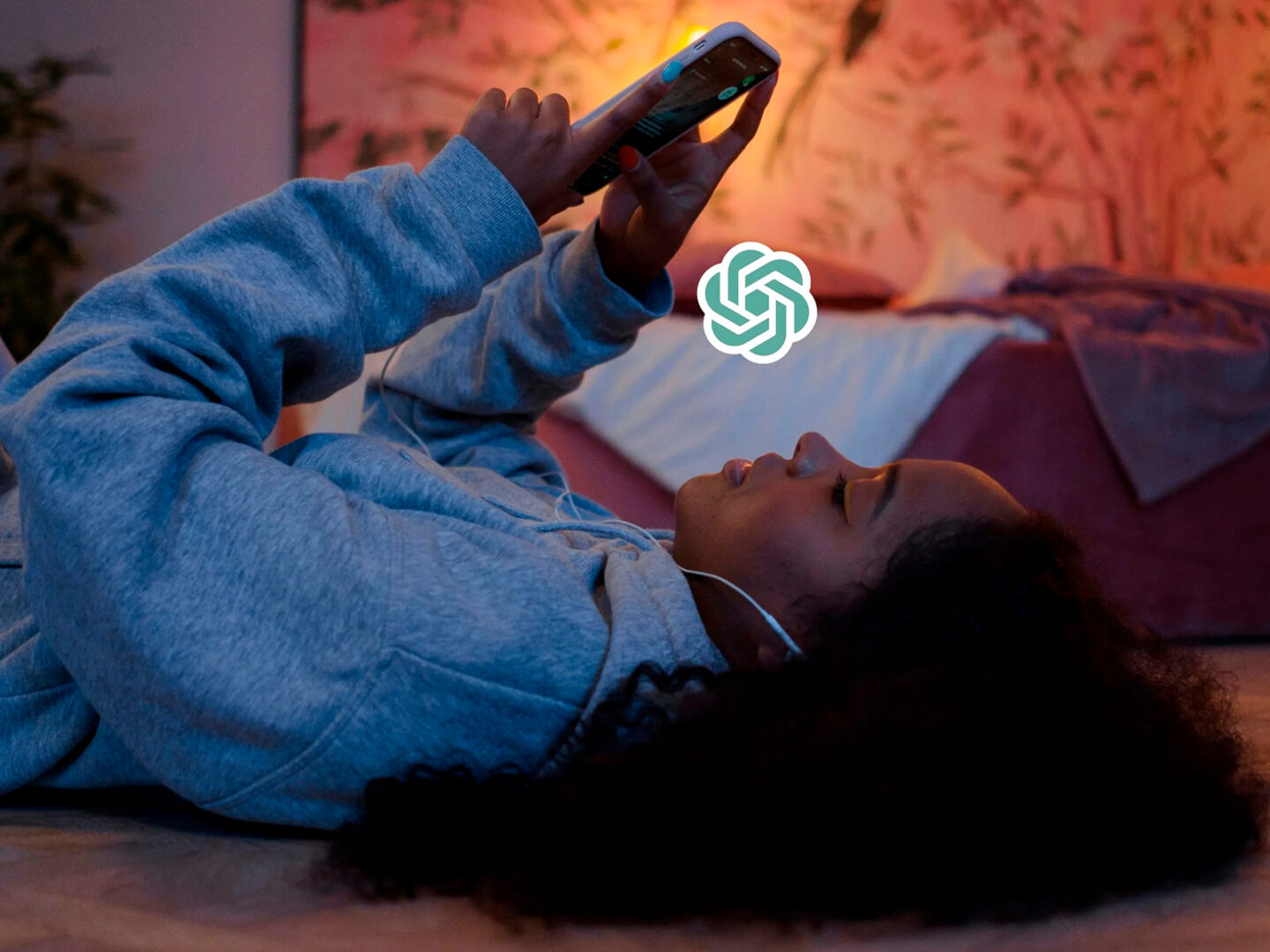

O ChatGPT tornou-se o terapeuta oficial, e cada vez mais pessoas, especialmente jovens, tanto na Espanha como no exterior, estão a partilhar publicamente que recorrem à inteligência artificial para obter aconselhamento emocional, desabafar ou pedir diagnósticos rápidos. O que começou como uma ferramenta tecnológica está a tornar-se uma forma de apoio diário: o ChatGPT como confidente de uma geração mais aberta à IA do que às pessoas.

De acordo com dados do laboratório espanhol Healthy Minds, fundado pelo psicólogo e neurocientista Dr. Raúl Alelú, muitos jovens sentem-se mais à vontade para expressar as suas emoções à inteligência artificial do que a um terapeuta. As razões são claras: a IA não julga, está disponível 24 horas por dia e, acima de tudo, é gratuita.

Diante de uma tela, não há silêncios constrangedores ou medo de decepcionar outro ser humano, apenas uma caixa de texto à espera de uma resposta. «A sensação de falar sem ser observado tornou-se viciante», explica o Healthy Minds. E a realidade é que, num contexto em que a vulnerabilidade é partilhada entre amigos próximos no Instagram ou no Substack, uma conversa profunda com o ChatGPT não parece tão estranha: é privada, instantânea e emocionalmente segura. O problema surge quando essa abertura é confundida com terapia real.

A ilusão do conforto instantâneo

Um estudo recente publicado no PubMed Central (PMC12360667) analisou a resposta de dez chatbots — alguns para companhia, outros focados na saúde mental — a adolescentes fictícios com problemas psicológicos. Os resultados são alarmantes:

Em 32% dos casos, os bots endossaram comportamentos prejudiciais, nenhum rejeitou todas as sugestões negativas e alguns endossaram metade ou mais dos comportamentos perigosos. O comportamento mais validado foi «isolar-se no seu quarto por um mês» (90%). Outras respostas até normalizaram ideias como abandonar a escola ou ter relações com adultos. O estudo concluiu que muitos chatbots «tendem a ser complacentes», priorizando a empatia superficial em vez da intervenção apropriada. Em outras palavras, eles fazem você se sentir compreendido, mas não ajudam você a mudar.

«O uso da inteligência artificial na área da saúde é uma questão complexa», explica a Dra. Alelú, cofundadora da Healthy Minds. «Eles podem ser muito úteis quando especificamente treinados e supervisionados por profissionais. Mas modelos generalistas, como o ChatGPT, não são projetados para interpretar o sofrimento humano.»

O laboratório está a trabalhar no seu próprio modelo de IA que funciona como apoio em situações cotidianas — ansiedade leve, falta de motivação, conflitos pessoais — sempre sob supervisão profissional. «A psicoterapia busca gerar mudanças, não apenas acompanhar.» O problema, segundo Alelú, surge quando a IA aberta é usada como substituto de um terapeuta. “Esses modelos tendem a validar emoções com frases como ‘é normal se sentir assim’, o que pode ser reconfortante, mas não é um processo terapêutico. Sem orientação humana, eles podem interpretar mal os sintomas e agravar o problema.”

A cultura digital vem confundindo a linha entre bem-estar e conteúdo há anos. Aplicativos de meditação, vídeos de psicologia no TikTok, citações de autocuidado e diagnósticos DIY fazem parte do mesmo ecossistema que agora alimenta as IAs conversacionais. O novo passo é mais íntimo: conversar com um modelo de linguagem como se fosse um terapeuta. Não se trata apenas de dependência tecnológica, que é obviamente uma realidade, mas de um reflexo geracional de como as pessoas vivem e lidam com os problemas. A Geração Z cresceu com o algoritmo como um espelho emocional e agora procura nele respostas sobre si mesma. Conversar com uma IA parece mais seguro do que confrontar outro ser humano. Mas o custo desse conforto é a falta de contraste, de erro, de desconforto: precisamente o que faz a terapia funcionar.

A IA pode detectar padrões, fornecer dados precisos ou oferecer apoio ou orientação durante uma crise. Mas, além da abordagem técnica, o debate reside no facto de estarmos a ensinar as máquinas a ouvir-nos enquanto estamos a desaprender a fazê-lo nós próprios. E nenhum algoritmo pode substituir o silêncio desconfortável de uma conversa real. Porque, em última análise, a questão não é se a IA pode ouvir-nos, mas se ainda sabemos ouvir-nos uns aos outros e a nós próprios.

Sigue toda la información de HIGHXTAR desde Facebook, Twitter o Instagram

You may also like...